I. Introduction▲

Les années 70 et 80 ont vu l'avènement, puis l'explosante ascension de la microinformatique. Son histoire est pleine d'anecdotes croustillantes et de guerres fratricides sanglantes. La littérature professionnelle foisonne de ces récits et l'ambition de cet article n'est pas de synthétiser ces 25 dernières années de technologie informatique, mais de donner un avant-goût de cette période riche en découvertes.

A l'heure où le serveur d'aujourd'hui devient l'ordinateur personnel de demain, la marge entre microinformatique et station de travail se restreint de plus en plus. Il est dès lors difficile de fixer des frontières infranchissables entre ces deux mondes.

Cet aperçu couvrira principalement l'évolution de la microinformatique, et plus particulièrement les "compatibles IBM". Nous observerons l'évolution technologique essentiellement au niveau de la carte-mère, non pas parce qu'elle n'a touché que ce composant, mais bien plutôt parce que la carte contient tous les points névralgiques de l'ordinateur.

II. La carte-mère en bref▲

Définition du microprocesseur▲

Un microprocesseur est, selon Intel, un système d'un ou plusieurs circuits intégrés qui utilisent la technologie des semi-conducteurs et la logique binaire pour proposer les fonctions des grands ordinateurs à une échelle beaucoup plus petite.

Technologie▲

Le rôle du processeur central est de traiter l'information (calculs, classements, comparaisons,...). Il se compose de l'unité de commande et de l'unité arithmétique et logique.

Les exigences des utilisateurs et les recherches des ingénieurs ont permis, dans les années 70, la mise au point de la technologie des circuits monolithiques intégrés à semi-conducteurs MOS/LSI (Metal Oxyde Semiconductor / Large Scale Integration). Ces circuits (plus de 5'800 au cm3) étaient capables de mémoriser plusieurs dizaines de milliers de bits. On parla alors d'intégration à grande échelle.

En 1980 est apparue l'intégration à très grande échelle avec les circuits MOS/VLSI (Very Large Scale Integration). On trouvait sur ces puces (chips) environ 600'000 circuits par cm3 qui pouvaient contenir jusqu'à 250'000 bits.

La norme TTL suivit, et c'est cette technologie qui est aujourd'hui utilisée avec les processeurs à consommation normale (5V et plus).

La norme CMOS est, quant à elle, réservée aux processeurs à faible consommation (pour les portables, les processeurs SL, SLC,...).

Intel a fabriqué ses processeurs selon ces deux normes : ceux qui suivent la technologie CMOS sont nommés 80Cx..86. Parallèlement, Intel continue d'employer la norme CMOS pour définir ses machines (ex: Pentium = technologie BiCMOS). En fait, toutes les appellations de type MOS (NMOS, MOSFET, PMOS) dépendent de la polarité des transistors.

Equivalents-transistors▲

Afin d'évaluer la capacité d'un processeur, l'une des méthodes est de calculer son intégration (le nombre d'équivalents-transistors). Au début de l'ère informatique, les mémoires étaient des transistors. Depuis l'avènement du silicone, des semi-conducteurs et des puces, le terme d'équivalents-transistors est utilisé afin de calculer le niveau d'intégration. La fameuse Loi de Moore (1964 ) qui stipule que la capacité de stockage doit doubler chaque 18 mois n'est pas si fausse, puisque la progression du 4004 au Pentium a été en moyenne de 170 % chaque 18 mois.

Proccesseurs et leur équivalent-transistors

| 4004 | 8008 | 8088/8086 | 80286 | 80386 | 80486 | Alpha XP | Indy | Pentium I | Pentium Pro | Pentium II | Pentium III | Pentium 4 | Itanium |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 2250 | 3500 | 29000 | 136000 | 285000 | 1200000 | 1680000 | 2600000 | 3100000 | 5500000 | 7500000 | 9500000 | 42000000 | 170000000 |

La miniaturisation améliore les performances des circuits intégrés, car elle permet de réduire les temps nécessaires aux signaux électriques pour circuler dans les composants, et donc le temps de traitement. De plus, plus l'intégration est importante et moins il y a de soudures, et donc de problèmes : l'intervalle moyen entre 2 pannes passa de quelques centaines d'heures en 1970 à quelques années en 1980.

Au niveau de l'intégration, les constructeurs sont de plus en plus au point aujourd'hui. Ils sont cependant confrontés aux mêmes problèmes qu'ils avaient eu à la fin des années 50 avec les filaments à incandescence : la surchauffe des circuits.

Supraconductivité▲

| IBM progresse dans le domaine des supraconducteurs, ces composants qui atteignent des vitesses de transfert fulgurantes, car sans frottement, donc sans surchauffe. Le problème resterait entier si ces circuits devaient être réfrigérés. Cependant, les savants de Big Blue (tous les derniers prix Nobel de physique) auraient réussi à utiliser des supraconducteurs à la température critique de -3°C (température à laquelle le coefficient de résistance tombe à 0), ce qui paraît tout à fait concevable pour les machines de demain |  |

Rôle de l'unité de commandes et de contrôle▲

Elle coordonne la circulation des informations à l'intérieur de l'unité centrale, synchronise le fonctionnement de l'unité centrale (rapide) et des périphériques (lents), vérifie la validité de toute information.

C'est elle qui fournit les adresses des instructions contenues en mémoire centrale. L'instruction extraite sera décodée par l'unité de contrôle.

Malgré le haut degré de fiabilité de la technique actuelle, l'unité de commande et de contrôle se teste automatiquement : chaque transfert est vérifié par répétition des opérations dans des circuits différents.

L'U.A.L.▲

L'unité arithmétique et logique est aussi appelée unité de traitement.

- L'unité arithmétique effectue les opérations arithmétiques (addition, soustraction, multiplication, division, exponentielle, racine carrée), place le signe du résultat et l'arrondit.

- L'unité logique effectue les tests de comparaison (par les circuits "comparateurs"), exécute les prises de décision entraînant une modification de la séquence des instructions.

Circulation des informations dans l'unité centrale▲

III. Du 4004 au Pentium : 25 années glorieuses pour Intel▲

1968 : Intel▲

Fondation de Intel qui se spécialise dans la conception et la production des circuits de mémoire.

1971 : le 4004, premier microprocesseur▲

| Intel présente le premier microprocesseur du monde : le 4004 possède 2'250 équivalents-transistors et une fréquence de 100 Hz. Il sert aux applications imbriquées (ex: automates) et est vendu aux fabricants de produits industriels et commerciaux. Truong réalisera chez Micra le premier micro-ordinateur du monde en utilisant ce processeur travaillant sur 4 bits de données. |

|

1972 : 8008 et micro▲

| Intel crée un microprocesseur de 8 bits, le 8008. Datapoint qui crée la puce doit en céder les droits à Intel pour des raisons financières. La fréquence double (200 Hz) et l'intégration atteint 3'500 jonctions. C'est l'avènement de la microinformatique. |

|

Avril 1974 : 8080 à usage universel▲

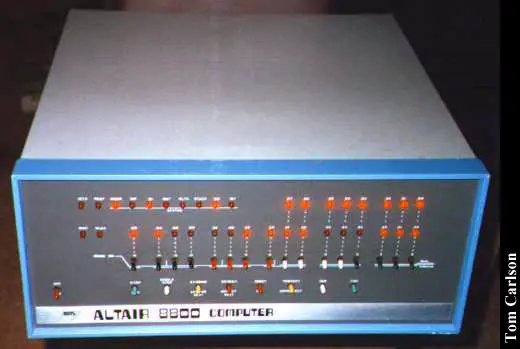

| Intel lance sur le marché le 8080, lui aussi sur 8 bits, commprennant un jeu d'instuctions plus complexe et 40 broches. C'est le premier succès commercial de la firme, l'avènement du premier ordinateur "grand public" - l'Altair (nom inspiré par Star Trek) de MITS, conçu par Ed Roberts - qu'il fallait malgré tout assembler soi-même. La fréquence décuple et passe à 2 MHz; l'intégration atteint 6'000 jonctions et le processeur est capable d'exécuter 64'000 instructions par secondes (0,064 Mips). Digital Research écrit le CP/M-80, un système d'exploitation pour ce microprocesseur qui s'imposera dans le domaine professionnel. La concurrence commence à se faire sentir avec le processeur compatible Z80 de Zilog. Motorola n'arrive pas à imposer son 6800 sorti plus tard. En revanche, C-Mos Technology, une société disparue aujourd'hui et composée de transfuges de chez Motorola, réussit à imposer son 6502 à un jeune constructeur : Apple. |

|

1975 : génération Bill Gates▲

Une jeune entreprise de Redmond (Etat de Washinton), jusqu'alors spécialisée dans la conception de softs pour Apple II et PET Commodore, décroche l'accord de confidentialité d'IBM. Deux étudiants, Bill Gates et Paul Allen, sont mandatés pour développer un système d'exploitation pour le nouveau PC de Big Blue (l'Acorn). Microsoft posa ainsi les fondations de ce qui allait devenir un empire.

1977 : l'année ordinateurs individuels▲

Trois ordinateurs individuels sortent en 1977 : il s'agit de l'Apple II, du TRS-80 de Radio Shack et du PET de Commodore.

|

|

|

| Apple II | TSR-80 | PET-Commodore |

|---|

Juin 1978 : le 8086 dans la tourmente ▲

En pleine guerre concurrentielle (Appel II à base de 6502, TRS-80 de Tandy utilisant un 8080), Intel sort la puce iAPX 86. Le 8086 sera le premier processeur à registres et bus de données de 16 bits fonctionnant à une fréquence de 4.77 MHz et intégrant 29'000 équivalents-transistors (5 fois plus que le 8080), ce qui lui permet d'exécuter 330'000 instructions par seconde (0.33 Mips). Jusqu'en 1981, le succès tardera, car aucun environnement 16 bits n'est encore développé. La similitude des jeux d'instructions des processeurs 8080 et 8086 fut par contre un atout non négligeable au point de vue du développement : les programmeurs systèmes se mirent à développer pour ce qui semblait devenir un standard.

Juin 1979 : l'entrée de gamme 8088▲

| Intel lance sur le marché une entrée de gamme : le 8088. Le bus de données n'est que de 8 bits. Cependant, il permet une meilleure utilisation des composants systèmes utilisant les bus de 8 bits. NEC développe en parallèle deux processeurs - le V20 et le V30 - qui peuvent être substitués au 8088 et au 8086 de manière transparente grâce à leur compatibilité; ils exécutent les instructions plus rapidement et en utilisant moins de courant. Les performances globales ont été améliorées en remplaçant le calcul d'adresse effectif des modes d'adressage du 8086 par un câblage prédéfini beaucoup plus rapide. |

|

1981 : IBM et Intel▲

Dès 1968, IBM avait voulu lancer sur le marché un modèle "populaire" d'ordinateur : Big Blue sortit donc sa série 5100 à base de 8086. Cependant, ce mini-ordinateur était encore trop cher (plus de 10'000 $) et ce ne fut pas un réel succès. Loin de baisser les bras, la direction générale d'IBM avait chargé William Lowe - directeur du laboratoire IBM implanté en Floride et fervent partisan de la microinformatique - de lui présenter un projet intéressant. Frank Cary, le président d'IBM, pensait qu'il fallait "400 personnes et 3 ans de réalisation" avant de commercialiser un produit. Lowe rétorque qu'il est capable de le faire en une année. Il obtient alors carte blanche et 2 semaines pour dresser son plan de bataille. Il regroupe 12 personnes de son laboratoire - les 12 Salopards - et remet à temps son rapport. Au niveau du processeur, leur choix s'est arrêté sur le 8088. Leur PC devra intégrer le clavier et le moniteur, ainsi qu'un lecteur de disquettes. En contradiction totale avec la politique d'IBM, Lowe dévoile ensuite tous les détails de conception de manière à pousser les programmeurs à créer des applications pour son appareil.

En choisissant le 8088, IBM scelle le succès d'Intel et la domination de son architecture 16 bits dans la micro-informatique. Ce coup sera terrible pour les deux grands rivaux d'Intel : Zilog avec son Z8000 périra, mais Motorola arrivera à imposer son architecture aux Macintosh deux ans plus tard.

Février 1982 : le mode protégé du 286▲

| Les premiers PC sont à peine sortis qu'Intel présente un nouveau circuit: l'iAPX 80286. Un câblage interne remplace des calculs fréquents et coûteux du 8086 : les performances s'en retrouvent améliorées. La réelle nouveauté de ce processeur est qu'il peut exécuter tous les programmes développés sur un 8086 en mode réel, mais aussi utiliser le mode d'adressage virtuel protégé. Cependant, le passage d'un mode à l'autre est très lent. Il faudra attendre 1987, Microsoft et IBM pour qu'un langage d'exploitation gère correctement ces deux modes. Le 80286 franchit pour la première fois la barre du 1 Mips (1,2 millions d'instructions par seconde, soit 3,6 fois plus que le 8086) avec 136'000 équivalents-transistors. C'est cette même année qu'Intel, à la demande d'IBM qui ne veut pas dépendre que d'un fournisseur, signe un accord d'échange de technologie avec AMD portant sur la 2ème génération des puces 286. |

|

|

Intel continue de développer parallèlement du matériel pour des applications imbriquées qui forment une part non négligeable de son marché. Elle développe le 80186 (iAPX 186) à 16 bits - et son petit frère à 8 bits, le 80188 (iAPX 188) - pour des firmes comme Apricot et Olivetti. Ces puces contiennent, en plus du microprocesseur, une bonne partie des circuits intégrés périphériques communément connectés au processeur pour ses travaux : un véritable ordinateur dans une puce ! De plus, le processeur reconnaissait le jeu d'instructions du 8086, plus quelques unes du mode réel du 80286.

1982 vit aussi l'avènement de Compaq. Cette société réussit à contourner la loi du copyright en écrivant son propre Bios entièrement compatible IBM |

|

Mode réel▲

Depuis le 8086, le mode d'adressage est dit réel : les adresses générées par le CPU sont directement envoyées sur le bus d'adresse sans aucune conversion. Elles correspondent donc directement à l'emplacement dans la mémoire physique. L'émulation du mode réel est toujours possible sur les machines actuelles.

Mode protégé▲

Dès le 80286, en mode d'adressage protégé, le processeur utilise un dispositif interne qui lui permet de protéger des données contre des accès non autorisés, de supporter le multitâche (avec un système d'exploitation adéquat) et de gérer la mémoire haute et supérieure grâce à un dispositif de stockage virtuel. Un nouveau jeu d'instructions apparaît pour cela, ce qui explique que les processeurs antérieurs ne peuvent être compatibles de ce point de vue là. Les programmes antérieurs ne peuvent être lancés en mode protégé sans violer de nombreuses protections. De plus, le passage du mode protégé au mode réel ne se déroule pas correctement sur le 80286.

1984 : la norme AT d'IBM▲

IBM sort le PC-AT (Advanced Technology) à base de 80286. Cette architecture sera dès lors la norme de toutes les machines à bus Isa.

Les bus▲

Lorsque le bus 16 bits de Intel fut normalisé par la volonté d'IBM en ISA, sa capacité était nettement suffisante. Cependant, le bus EISA 32 bits fit bientôt son apparition sur les machines haut de gamme. Un peu plus tard, IBM, voulant faire cavalier seul, lança ses propres bus, le MCA16 (en 16 bits) et le MCA32 (en 32 bits). Ceux-ci se différenciaient essentiellement des bus d'Intel par le taux de transfert plus élevé (1). Les constructeurs taïwanais voulurent améliorer certaines caractéristiques de leurs machines à bas prix. Ils commencèrent à greffer aux bus 4 à 8 fils parallèles qui amélioraient le transfert de données (2). Cette solution était loin d'être satisfaisante. Ils eurent alors l'idée de créer des branchements avant l'interface bus, directement à la sortie du processeur. Ce bricolage leur permit de créer le bus local (3) Avec ces bus, il n'y a en principe que deux connecteurs (un pour une carte graphique VESA et l'autre pour un contrôleur disque éventuel). Ce mode rencontre des problèmes insurmontables sur des machines ayant un processeur de plus de 40 MHz (P5). De plus, puisque ces branchements sont fait avant l'interface bus, il n'y a aucun contrôle d'interruptions,... d'où certains problèmes de compatibilité entre plusieurs cartes. Certains constructeurs (Dell, H.P., AMD,...) ont choisis d'incorporé cette technologie de bus local dans leurs processeurs et d'en faire un bus propriétaire, mais le problème de la fréquence reste entier. VESA reste un bus ne pouvant migrer sur Pentium défini par quelques constructeurs afin d'améliorer à bon prix les performances graphiques. Intel (bien que faisant partie du consortium Vesa) remédie partiellement à ces bricolages en lançant ce qui promet de devenir une nouvelle norme : le bus local 64 bits autoconfigurable PCI (Peripheral Component Interconnect). Il suffira alors de brancher une carte pour que celle-ci soit configurée automatiquement (plus de jumper). Cependant, il n'est pour l'instant pas possible d'y brancher un contrôleur disque comme sur le VESA.

| 4004 | 8008 | 8088 | 8086 | 286 | 386SX | 386DX | 486SX | 486DX | 486DX2 | Pentium | Alpha | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Taille du bus de données | 4 | 8 | 8 | 16 | 16 | 16 | 32 | 32 | 32 | 32 | 64 | 64 |

| Taille du bus d'adresse | 4 | 8 | 20 | 20 | 24 | 32 | 32 | 32 | 32 | 32 | 32 | 64 |

| Taille des registres généraux | 4 | 6 | 16 | 16 | 16 | 32 | 32 | 32 | 32 | 32 | 32-64 | 64 |

Octobre 1985 : le mode V86 du 386▲

Mode 8086 virtuel (V86)▲

Pour pallier aux problèmes que posait le passage entre les deux modes susmentionnés, Intel développe, dès le 80386, le mode 8086 virtuel. Avec un système d'exploitation approprié, un 80386 peut effectuer en parallèle des tâches en mode réel 8086, en mode protégé 80286 et en mode protégé 80386, grâce à sa compatibilité avec le code objet 8086. C'est cette amélioration qui propulsa le 80386 sur le marché.

1986 : essai de Compaq▲

| Compaq propose un modèle équipé du 80386 DX, le Compaq Deskpro 386, mais ne rencontre pas un franc succès. Les coûts sont encore trop élevés, mais on ne peut les briser. Il faut trouver une entrée de gamme. |

|

Juin 1988 : SX et guerre des prix▲

| Intel propose une entrée de gamme pour la génération 386 : le 80386 SX, un faux 32 bits, puisque son bus de données n'est que de 16 bits. Les prix ainsi baissés favorisent la ruée sur le monde des 80386. |

|

Avril 1989 : 80386 "gonflé" cherche 80486▲

Intel diffuse les premiers 80486 DX. Fonctionnellement, ils ne diffèrent pas énormément du 80386. Ils intègrent cependant un coprocesseur arithmétique (rapidité d'exécution pour la CAO, les tableurs, les graphiques, la PAO : jusqu'à 70%) qui pouvait se trouver sur la carte-mère du 80386, et une mémoire cache de 8 Ko qui permet de stocker à l'avance le code et les données, entraînant ainsi un fonctionnement très rapide, non ralenti par les accès à la mémoire (gain de près de 20%). Cette nouvelle technologie ouvre grand la porte aux applications graphiques. Le nombre de jonctions décuple (1'200'000, soit 8,8 fois plus que le 80386) et la barre des 20 Mips est dépassée pour une fréquence de 25 MHz. Des versions à 33 et 50 MHz sortent aussi, ainsi qu'une à 40 chez... AMD. La version à 50 MHz d'Intel posera cependant d'énormes problèmes.

Avec le 486, survient un problème technique qu'Intel n'a pu prévoir. L'organisation interne du microprocesseur est tellement modifiée que certaines instructions, en particulier les opérandes adressant la mémoire, sont exécutées beaucoup plus rapidement (parfois plusieurs en un cycle d'horloge); d'autres, par contre, s'exécutent plus lentement. Cela pose d'énormes problèmes aux programmeurs en assembleurs qui doivent optimiser la vitesse d'exécution de leur code pour toute la famille 80x86.

Avril 1991 : la génération SX▲

Intel réitère sa baisse de prix en lançant sur le marché l'entrée de gamme du monde 486 à des prix compétitifs : le 80486 SX qui n'est autre qu'un 80486 DX amputé du coprocesseur. Au début, les 80486 DX ayant des problèmes de coprocesseur étaient dégradés en SX par une simple coupure au laser qui déconnectait le coprocesseur.

Mars 1992 : bricolage et overdrives▲

| Avec le 486DX-50 surviennent des problèmes techniques majeurs de surchauffe des circuits. Intel met alors au point une astuce pour qu'un processeur fonctionne deux fois plus vite que la carte-mère. Il commercialise le 80486 DX2, processeur rigoureusement compatible broche à broche avec le 80486 DX, mais qui intègre un doubleur de fréquence lui permettant de calculer deux fois plus vite. La première version, le 80486 DX2/50 était en fait un 80486DX-25 doublé, le doubleur de fréquence n'acceptant pas, pour des raisons techniques, des cartes-mère ayant des fréquences plus élevées. Le nombre d'instructions par secondes double (40 Mips), mais seules les opérations internes au processeur suivent cette progression. Actuellement, le plus rapide de cette famille de circuits est le 80486DX2-66, un 33 doublé. On parle aussi de DX3 qui permettrait de faire travailler le processeur à une vitesse trois fois plus rapide que la carte-mère. |  |

Danger : fréquence d'horloge trop élevée▲

La fréquence à laquelle est cadencé un processeur est devenu un critère de choix lors de l'achat d'un ordinateur. Elle définit en réalité, non pas la rapidité d'exécution de l'ordinateur, mais la vitesse à laquelle il enchaîne ses instructions. En principe, si la fréquence d'horloge double, le processeur emploiera deux fois moins de temps pour effectuer les mêmes instructions. Cependant, un processeur n'est pas un malin génie qui peut, à son gré, choisir à quelle vitesse il travaille. Il arrive que la fréquence soit trop élevée par rapport aux performances du processeur : il existe une fréquence maximale à partir de laquelle le processeur n'est plus fiable (s'il n'a pas fini d'exécuter une instruction lorsque la suivante arrive). Au point de vue commercial, les constructeurs filtrent leurs processeurs afin de choisir ceux qui exécutent aux plus hautes fréquences les jeux d'instructions. C'est de ce déclassement que sont issus les les meilleurs marchés.

Mai 1993 : Pentium, la carte de la dernière chance ?▲

Après une bonne année de publicité, Intel lance sur le marché ce qui ressemble étrangement à sa dernière carte : le Pentium (code d'origine : P5 i586 PACK4). Ce nouveau processeur fonctionne à des fréquences de 60 et de 66 MHz (cette dernière lui permettant d'atteindre 112 Mips) et possède une architecture interne de 32 bits, bien que son bus de données externe soit de 64 bits. Il peut donc travailler simultanément sur deux nombres de 32 bits chacun. Son intégration atteint les 3'100'000 équivalents-transistors, soit 2,6 fois plus que le 80486. Il intègre de plus 16 Ko de mémoire cache : 8 Ko pour les données et 8 pour les instructions. Intel envisage de commercialiser une version bridée du Pentium (le P24T). Une version tournant à 100 MHz est attendue pour le milieu de l'année 1994.

En fait, le Pentium est un CICS par son architecture interne et sa compatibilité descendante avec la famille 80x86, mais son jeu d'instruction a été réduit. Il est donc l'hybride de la famille d'Intel.

La technologie Pentium permet à Intel de reprendre le lead sur un marché qui s'était gentiment fait grignoté par divers concurrents (VLSI, Opti, Chips & Technology), ceux-ci n'étant pas à même de fournir un équivalent stable.

Dec Alpha : le PC le plus rapide du monde▲

| Alors qu'Intel annonçait que son Pentium devait atteindre les 66 MHz de fréquence interne et externe, et s'approcher de l'architecture 64 bits (bus de données), Digital sortait son DECpc axp 150, un ordinateur comprenant le tout nouveau processeur 64 bits Alpha qui permet d'atteindre des fréquences de 150 à 200 MHz. Le DEC 21064 possède un jeu d'instructions réduit (RISC), contrairement aux processeurs Intel CISC. Les applications fonctionnant avec un processeur CISC doivent donc être recompilées pour fonctionner avec un RISC. Cependant, Digital a signé un pacte d'alliance avec Microsoft en ce qui concerne Windows NT. Il est donc en possession de la plupart des codes sources des nombreux logiciels fonctionnant sous Windows 3.1 et a été mandaté afin de créer un parc logiciel compatible RISC. De plus, DEC construit des PC à processeur Intel : il a été un des rares constructeurs à pouvoir tester le Pentium; Digital maîtrise ainsi les 2 technologies. |

|

| Son processeur 21064 sera donc en mesure d'émuler les systèmes suivants : Open VMS AXP & VAX, Dec OSF/1, ULTRIX, IBM systems, SCO UNIX, MS-Dos et Windows, OS/2, POSIX 2.0, Unix, Open VMS, Macintosh systems, VT terminals, IBM 3270 terminals, X terminals. Il peut, de plus, accueillir les systèmes d'exploitation suivants: Windows NT, Open VMS AXP Dec OSF/1 AXP. Ce n'est pas forcément un hasard si Windows NT a été annoncé le 24 mai et le DECpc axp 150 le ... 25 mai 1993. Malgrés des inventions aussi performantes que l'Alpha ou Open VMS, DEC finira par être gobé par Compaq, qui fusionnera à son tour avec Hewlett-Packard. |

|

Power2 : un coup de butoir contre Intel▲

| IBM n'avait pas craint d'utiliser ses propres composants, quitte à s'éloigner quelque peu de ses concurrents. Cependant, la guerre que se livraient les différents constructeurs allait à l'encontre des utilisateurs : Macintosh, compatible IBM, Next, que choisir ? Au début, la puissance graphique était l'atout des Macintosh tandis que le monde comptable appartenait aux PC, mais ces temps sont révolus. IBM s'allie donc à Motorola et Apple ( plus Solaris, Bull,...) afin de mettre au point un processeur RISC compatible IBM et Apple. Ce processeur est connu sous la dénomination de PowerPC (Performance Optimization With Enhanced Risc). Le PowerPC est déjà incorporé à la famille IBM RISC System/6000. Ce processeur avait une fréquence qui variait entre 30 MHz et 62,5 MHz. |

|

| Pour les serveurs et gros systèmes, IBM sort le processeur Power2 603. Sa fréquence varie entre 55,5 et 71,5 MHz D'ors et déjà, on connaît le nom des 2 prochaines puces PowerPc : le 604 et le 620 PowerPC. Le 601 reste l'entrée de gamme, le 603 intègre un cache de données et un cache d'instructions, le 604 peut être multiprocesseur et comprend une unité d'exécution additionnelle, et le 620 est réservé aux ordinateurs haut de gamme (multiprocesseur, hautes performances,...) Le PowerPC équipera les Mac d'Apple près d'une décennie avant qu'Apple décide de retourner sur ces processeurs Intel. Cette technologie équipe encore de nos jours la plupart des i et pSerie d'IBM. |

|

Automne 1995 : Pentium Pro▲

Intel sort en autonme 1995 le Pentium Pro, riche de 5.5 millions d'équivalent-transistors. Il répond aux exigences toujours plus gourmandes des applications de CAO (d'habitude toujours sous Mac) et de calculs scientifiques. La puce Pentium Pro intègre une mémoire cache.

1997: Pentium II ▲

La technologie Intel MMX est intégrée à ce nouveau processeur de 7.5 millions d'équivalents-transistors. Elle permet à présent le traitement d'applications multimédia. La gamme Xeon est réservée aux serveurs et stations de travail de milieu de gamme.

1999 : Pentium III et Celeron▲

Ce nouvelle génération de processeur (gravure à 0.25 microns) contient 9.5 millions d'équivalents-transistors et un nouveau jeu d'instructions pour les application de reconnaissance vocale et de 3D.

2000 : Pentium 4▲

Juin 2001 : Itanium, la fin du CISC ?▲

Intel, aidé de Bull et de HP, sort un processeur entièrement 64 bits, ceci afin de concurrencer le Dec-Alpha. Son nom de code est Merced, mais il sera baptisé Itanium. Ses performances ne répondent cependant pas tout de suite aux attentes compte tenu d'un module défaillant et d'une cadence trop élevée (2GHz) et instable

RISC et CISC▲

Les processeurs actuels sont classés en deux catégories selon le type d'instruction qu'ils proposent au programmeur. Le premier type de processeur est appelé RISC ou Reduced Instruction Set Computer (ordinateur à jeu d'instructions réduit). Il est conçu pour proposer un jeu d'instructions réduit au minimum. Les instructions généralement considérées de haut niveau, comme la multiplication de deux opérandes, doivent être programmées à l'aide d'instructions primitives.

Les raisons principales qui ont conduit à cette approche sont qu'en simplifiant le jeu d'instructions, on facilite énormément la conception de la puce. On ralentit d'autant les temps d'exécution.

Le nombre d'instructions disponibles dans le jeu d'un processeur CISC - Complex Instruction Set Computer - est une bonne indication de ses possibilités. Le jeu d'instructions du 8086, connu sous le nom de jeu de base, est repris dans tous ses successeurs. Les processeurs plus récents ont généralement été dotés de nouvelles instructions pour supporter leur mode protégé (dès le 80286) ou des registres plus grands et des opérations arithmétiques correspondantes (dès le 80386).

2004 : Intel stoppe la cadence▲

Pour des raisons de coûts liés à la technologie qu'il faudrait mettre en place, Intel renonce au projet d'un Pentium 4 cvadencé à 4 GHz et s'oriente vers d'autres possibilité d'augmenter la performance de ses processeurs que celle d'augmenter la fréquence.

18 juillet 2006 : Itanium 2 et multi-coeurs▲

V. Conclusion▲

L'histoire des ordinateurs individuels ne fait que commencer. Plus la technologie essaie de répondre aux besoins des utilisateurs et plus ces besoins deviennent grands. Techniquement parlant, les machines sont très évoluées, et de nouveaux horizons s'ouvrent (ex: supraconductivité, compatibilité entres les systèmes... D'énormes progrès restent à faire afin de les doter de logiciels utilisant au mieux les performances matérielles.

On dit souvent que l'homme n'utilise qu'un très faible pourcentage des capacités de son cerveau. Le processeur est quant à lui souvent considéré comme le cerveau électronique de l'ordinateur. Nous arrivons dans une période où ses capacités seront, elles aussi, sous-exploitées par manque de connaissance.

Lors de la préparation de cet article, j'ai pu remarquer à quel point les prévisions sur les machines futures étaient faites hâtivement par la presse grand public dite spécialisée. Il est primordial de ne pas tout croire ce qu'on lit et de trouver des sources objectives : seul le constructeur peut nous fournir une documentation technique adéquate.

VI. Sources▲

Revues▲

- BEACHLER J.-P., Power PC : le loup dans la bergerie dans IB Suisse, n°231, novembre 1993, p.16

- HALFHILL Tom R., Intel Launches Rocket in a Soket dans Byte, mai 1993, p. 92 à 108

- RANGLARET Didier, Voyage au coeur du Pentium dans L'Ordinateur Individuel, n°43, septembre 1993, p. 182 à 191

- Ordinateurs i486 : évolutifs par définition dans Intel News, n°18, 1992, p. 1-2

- Pour en finir avec le débat "RISC contre CISC" dans Intel News, n°18, 1992, p. 6-7

- BOUCHARD Dominique, Les bons ordinateurs et les mauvais dans L'Ordinateur Individuel, n°18, mai 1991, p. 71 à 80

- DUMONTIER Michel, Overdrive : Le 486 turbo dans L'Ordinateur Individuel, n°30, juin 1992, p. 17 à 20

- CHEVALET Michel, Voyage au centre du micro-ordinateur, dans Compatibles PC magazine, n°68, juillet-août 1993, p. 78 à 81

- MERY D. et KHELOUFI A., La Galaxie des Processeurs, dans PC Expert, n°10, janvier 1993, p.210 à 236

- THOMPSON T., PowerPC : Performs for less, dans Byte, n°9, août 1993, p 56 à 90

- E. HILLER et M. GAMBIER, "Nous ne voulons pas tuer Intel", dans Soft & Micro, n°98, juillet-août 1993, p. 12

- Puissance Pentium, dans PC Expert, n° 14, mai 1993, p. 122 à 136

- B. FERRET & J. PAOLI, Les turbo-PC entrent dans la course, dans Soft & Micro, n°96, mai 1993, p. 62 à 66

- Le PC le plus rapide du monde, dans DEC Info, n°9, mai/juin 1993, p. 6 à 8

- Windows NT et le DECpc AXP 150, dans DEC Info, n°9, mai/juin 1993, p. 4 et 5

- Windows NT, dans DEC Info, n°9, mai/juin 1993, p. 10 à 13

Documentation technique▲

- Intel 386*SX Microprocessor Family product Briefs, 1990

- Guide de performance de la famille Intel 486*, 1991

- The ultimate collection Intel, 1992

- Intel 486*DX2 Microprocessor Performance Briefs, juin 1992

- The Entry-Level Standard For Business Computing : The Intel486* SX Microprocessor, 1992

- The ultimate collection Intel, 1992

- The ultimate collection Intel, juillet 1993

- Pentium* Processor : Preliminary, mars 1993

- Pentium* Processor : Performance Brief, mars 1993

- Pentium* Processor : Family Product Briefs, 1993

- L'architecture Intel, 4e édition

- Alpha AXP Systems Handbook, 1993

- Alpha Architecture Handbook, 1992

- Alpha AXP Systems Summary

- Alpha AXP* : The Competitive Edge Can Be Yours

- DECpc axp 150 Personal Computer

- DECchip 21064-AA/BA Microprocessors

- Datamation : For Corporate Computing Professionnals Worldwide

- PowerPC - Power2 : les architecture, 1993

- RISC/System/6000 POWERstation and POWERserver 200 Series, 1993

- IBM, Motorola Achieve First Silicon of the PowerPC 603 Microprocessor, septembre

Livres▲

- HUMMEL Robert, Processeurs et coprocesseurs, Ed. Dunod, Paris, 1992, p. 1 à 10 et 29 à 48

- TISCHER Michael, La Bible PC, Micro Application, Paris, 1992, p. 19 à 33

- Histoire de puces dans Le monde des ordinateurs, Time Life, Amsterdam, 1989, p. 7 à 32, 68-69 et 90 à 98

- L'ordinateur personnel dans Le monde des ordinateurs, Time Life, Amsterdam, 1989, p. 7 à 28

Séminaires▲

- KAISER Freddy, Séminaire sur les composants d'un micro, ETCI, Sierre, 1990